Konfiguracja Wtyczki

Konfiguracja Modelu

Standardowa Konfiguracja Modelu

Węzeł Create Runtime Viseme Generator używa domyślnych ustawień, które sprawdzają się w większości scenariuszy. Konfiguracja jest obsługiwana poprzez właściwości węzła mieszania w Animation Blueprint.

Aby poznać opcje konfiguracji Animation Blueprint, zobacz sekcję Konfiguracja Synchronizacji Warg poniżej.

Konfiguracja Realistycznego Modelu

Węzeł Create Realistic MetaHuman Lip Sync Generator akceptuje opcjonalny parametr Configuration, który pozwala dostosować zachowanie generatora:

Typ Modelu

Ustawienie Model Type określa, której wersji realistycznego modelu użyć:

| Typ Modelu | Wydajność | Jakość Wizualna | Obsługa Szumu | Zalecane Zastosowania |

|---|---|---|---|---|

| Wysoko Zoptymalizowany (Domyślny) | Najwyższa wydajność, najniższe użycie CPU | Dobra jakość | Może wykazywać zauważalne ruchy ust przy szumie tła lub dźwiękach innych niż głos | Czyste środowiska audio, scenariusze krytyczne pod względem wydajności |

| Częściowo Zoptymalizowany | Dobra wydajność, umiarkowane użycie CPU | Wysoka jakość | Lepsza stabilność z zaszumionym audio | Zrównoważona wydajność i jakość, mieszane warunki audio |

| Oryginalny | Nadaje się do użycia w czasie rzeczywistym na nowoczesnych CPU | Najwyższa jakość | Najbardziej stabilny z szumem tła i dźwiękami innymi niż głos | Produkcje wysokiej jakości, zaszumione środowiska audio, gdy potrzebna jest maksymalna dokładność |

Ustawienia Wydajności

Intra Op Threads: Kontroluje liczbę wątków używanych do wewnętrznych operacji przetwarzania modelu.

- 0 (Domyślne/Automatyczne): Używa automatycznego wykrywania (zazwyczaj 1/4 dostępnych rdzeni CPU, maksymalnie 4)

- 1-16: Ręczne określenie liczby wątków. Wyższe wartości mogą poprawić wydajność na systemach wielordzeniowych, ale zużywają więcej CPU

Inter Op Threads: Kontroluje liczbę wątków używanych do równoległego wykonywania różnych operacji modelu.

- 0 (Domyślne/Automatyczne): Używa automatycznego wykrywania (zazwyczaj 1/8 dostępnych rdzeni CPU, maksymalnie 2)

- 1-8: Ręczne określenie liczby wątków. Zwykle utrzymywane na niskim poziomie dla przetwarzania w czasie rzeczywistym

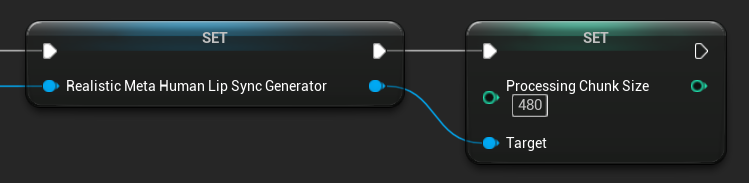

Rozmiar Porcji Przetwarzania

Processing Chunk Size określa, ile próbek jest przetwarzanych w każdym kroku wnioskowania. Wartość domyślna to 160 próbek (10ms audio przy 16kHz):

- Mniejsze wartości zapewniają częstsze aktualizacje, ale zwiększają użycie CPU

- Większe wartości zmniejszają obciążenie CPU, ale mogą zmniejszyć responsywność synchronizacji warg

- Zaleca się używanie wielokrotności 160 dla optymalnego wyrównania

Konfiguracja Modelu z Obsługą Nastroju

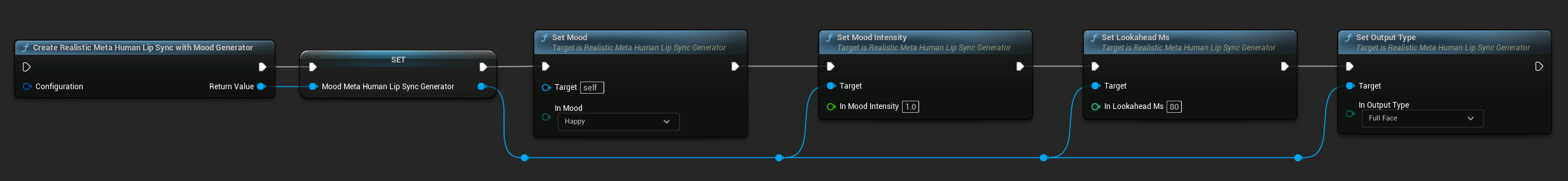

Węzeł Create Realistic MetaHuman Lip Sync With Mood Generator zapewnia dodatkowe opcje konfiguracji poza podstawowym modelem realistycznym:

Podstawowa Konfiguracja

Lookahead Ms: Czas wyprzedzenia w milisekundach dla poprawionej dokładności synchronizacji warg.

- Domyślne: 80ms

- Zakres: 20ms do 200ms (musi być podzielne przez 20)

- Wyższe wartości zapewniają lepszą synchronizację, ale zwiększają opóźnienie

Output Type: Kontroluje, które kontrolki twarzy są generowane.

- Full Face: Wszystkie 81 kontrolek twarzy (brwi, oczy, nos, usta, szczęka, język)

- Mouth Only: Tylko kontrolki związane z ustami, szczęką i językiem

Performance Settings: Używa tych samych ustawień Intra Op Threads i Inter Op Threads co zwykły model realistyczny.

Ustawienia Nastroju

Dostępne Nastroje:

- Neutralny, Szczęśliwy, Smutny, Odraza, Gniew, Zaskoczenie, Strach

- Pewny siebie, Podekscytowany, Znudzony, Zabawowy, Zdezorientowany

Intensywność Nastroju: Kontroluje, jak mocno nastrój wpływa na animację (0.0 do 1.0)

Kontrola Nastroju w Czasie Rzeczywistym

Możesz dostosować ustawienia nastroju podczas działania za pomocą następujących funkcji:

- Set Mood: Zmień aktualny typ nastroju

- Set Mood Intensity: Dostosuj, jak mocno nastrój wpływa na animację (0.0 do 1.0)

- Set Lookahead Ms: Zmodyfikuj czas wyprzedzenia dla synchronizacji

- Set Output Type: Przełącz między kontrolkami Full Face i Mouth Only

Przewodnik Wyboru Nastroju

Wybierz odpowiednie nastroje na podstawie treści:

| Nastrój | Najlepsze Do | Typowy Zakres Intensywności |

|---|---|---|

| Neutralny | Ogólna rozmowa, narracja, stan domyślny | 0.5 - 1.0 |

| Szczęśliwy | Treści pozytywne, pogodne dialogi, świętowanie | 0.6 - 1.0 |

| Smutny | Treści melancholijne, sceny emocjonalne, ponure momenty | 0.5 - 0.9 |

| Odraza | Reakcje negatywne, treści niesmaczne, odrzucenie | 0.4 - 0.8 |

| Gniew | Agresywne dialogi, sceny konfrontacyjne, frustracja | 0.6 - 1.0 |

| Zaskoczenie | Nieoczekiwane wydarzenia, objawienia, reakcje szoku | 0.7 - 1.0 |

| Strach | Sytuacje zagrażające, niepokój, nerwowe dialogi | 0.5 - 0.9 |

| Pewny siebie | Prezentacje profesjonalne, dialogi przywódcze, asertywna mowa | 0.7 - 1.0 |

| Podekscytowany | Treści energetyczne, ogłoszenia, entuzjastyczne dialogi | 0.8 - 1.0 |

| Znudzony | Treści monotonne, niezainteresowane dialogi, zmęczona mowa | 0.3 - 0.7 |

| Zabawowy | Swobodna rozmowa, humor, lekkie interakcje | 0.6 - 0.9 |

| Zdezorientowany | Dialogi z wieloma pytaniami, niepewność, zakłopotanie | 0.4 - 0.8 |

Konfiguracja Animation Blueprint

Konfiguracja Synchronizacji Warg

- Standard Model

- Realistic Models

Węzeł Blend Runtime MetaHuman Lip Sync ma opcje konfiguracji w panelu właściwości:

| Właściwość | Domyślna | Opis |

|---|---|---|

| Interpolation Speed | 25 | Kontroluje, jak szybko ruchy warg przechodzą między wizemami. Wyższe wartości skutkują szybszymi, bardziej nagłymi przejściami. |

| Reset Time | 0.2 | Czas w sekundach, po którym synchronizacja warg jest resetowana. Przydatne, aby zapobiec kontynuowaniu synchronizacji warg po zatrzymaniu audio. |

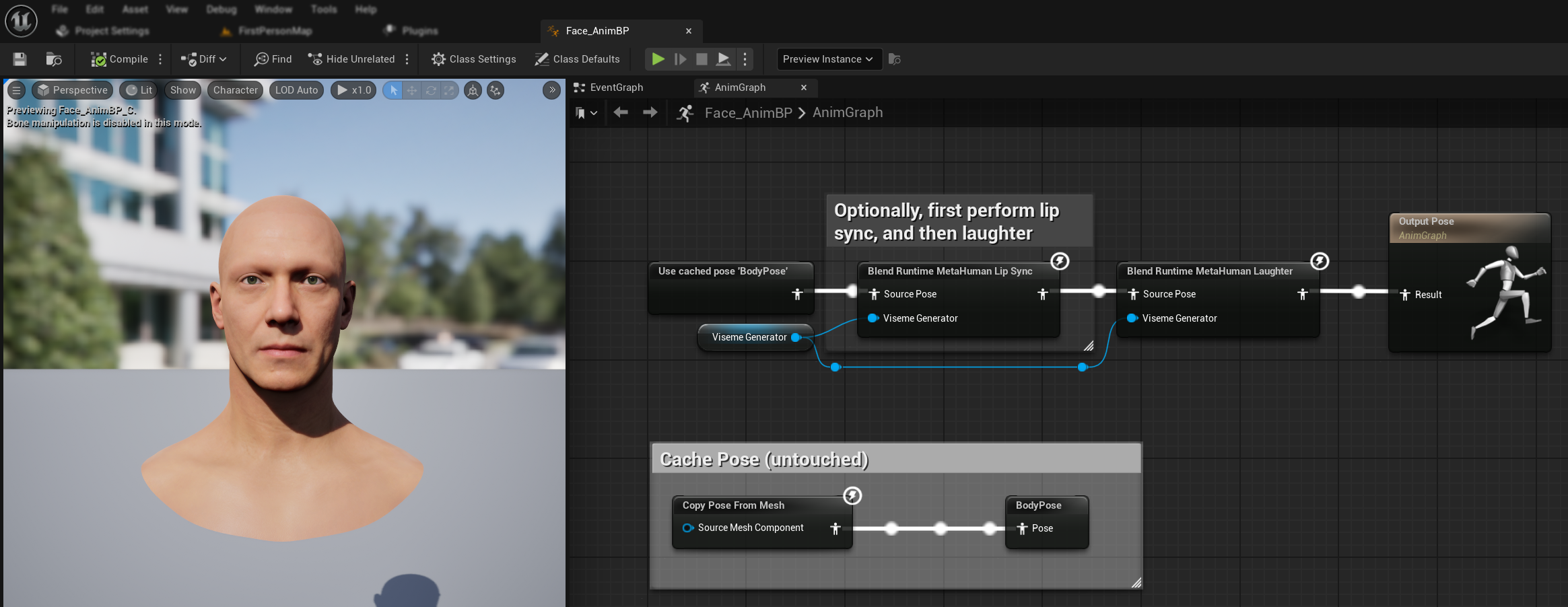

Animacja Śmiechu

Możesz również dodać animacje śmiechu, które będą dynamicznie reagować na śmiech wykryty w audio:

- Dodaj węzeł

Blend Runtime MetaHuman Laughter - Podłącz swoją zmienną

RuntimeVisemeGeneratordo pinuViseme Generator - Jeśli już używasz synchronizacji warg:

- Podłącz wyjście z węzła

Blend Runtime MetaHuman Lip SyncdoSource PosewęzłaBlend Runtime MetaHuman Laughter - Podłącz wyjście węzła

Blend Runtime MetaHuman Laughterdo pinuResultwOutput Pose

- Podłącz wyjście z węzła

- Jeśli używasz tylko śmiechu bez synchronizacji warg:

- Podłącz swoją pozę źródłową bezpośrednio do

Source PosewęzłaBlend Runtime MetaHuman Laughter - Podłącz wyjście do pinu

Result

- Podłącz swoją pozę źródłową bezpośrednio do

Gdy śmiech zostanie wykryty w audio, twoja postać będzie dynamicznie animowana odpowiednio:

Konfiguracja Śmiechu

Węzeł Blend Runtime MetaHuman Laughter ma własne opcje konfiguracji:

| Właściwość | Domyślna | Opis |

|---|---|---|

| Interpolation Speed | 25 | Kontroluje, jak szybko ruchy warg przechodzą między animacjami śmiechu. Wyższe wartości skutkują szybszymi, bardziej nagłymi przejściami. |

| Reset Time | 0.2 | Czas w sekundach, po którym śmiech jest resetowany. Przydatne, aby zapobiec kontynuowaniu śmiechu po zatrzymaniu audio. |

| Max Laughter Weight | 0.7 | Skaluje maksymalną intensywność animacji śmiechu (0.0 - 1.0). |

Uwaga: Wykrywanie śmiechu jest obecnie dostępne tylko w Modelu Standardowym.

Węzeł Blend Realistic MetaHuman Lip Sync ma opcje konfiguracji w panelu właściwości:

| Właściwość | Domyślna | Opis |

|---|---|---|

| Interpolation Speed | 30 | Kontroluje, jak szybko mimika twarzy przechodzi podczas aktywnej mowy. Wyższe wartości skutkują szybszymi, bardziej nagłymi przejściami. |

| Idle Interpolation Speed | 15 | Kontroluje, jak szybko mimika twarzy wraca do stanu bezczynnego/neutralnego. Niższe wartości tworzą gładsze, bardziej stopniowe powroty do pozy spoczynkowej. |

| Reset Time | 0.2 | Czas w sekundach, po którym synchronizacja warg resetuje się do stanu bezczynnego. Przydatne, aby zapobiec kontynuowaniu wyrazów twarzy po zatrzymaniu audio. |

| Preserve Idle State | false | Po włączeniu, zachowuje ostatni stan emocjonalny podczas okresów bezczynności zamiast resetować do neutralnego. |

| Preserve Eye Expressions | true | Kontroluje, czy kontrolki twarzy związane z oczami są zachowywane podczas stanu bezczynnego. Skuteczne tylko wtedy, gdy Preserve Idle State jest włączone. |

| Preserve Brow Expressions | true | Kontroluje, czy kontrolki twarzy związane z brwiami są zachowywane podczas stanu bezczynnego. Skuteczne tylko wtedy, gdy Preserve Idle State jest włączone. |

| Preserve Mouth Shape | false | Kontroluje, czy kontrolki kształtu ust (z wyłączeniem ruchów specyficznych dla mowy, takich jak język i szczęka) są zachowywane podczas stanu bezczynnego. Skuteczne tylko wtedy, gdy Preserve Idle State jest włączone. |

Zachowanie Stanu Bezczynnego

Funkcja Preserve Idle State rozwiązuje kwestię, w jaki sposób model Realistyczny obsługuje okresy ciszy. W przeciwieństwie do modelu Standardowego, który używa dyskretnych wizemów i konsekwentnie wraca do wartości zerowych podczas ciszy, sieć neuronowa modelu Realistycznego może utrzymywać subtelne pozycjonowanie twarzy, które różni się od domyślnej pozy spoczynkowej MetaHumana.

Kiedy włączyć:

- Utrzymywanie wyrazów emocjonalnych między segmentami mowy

- Zachowywanie cech osobowości postaci

- Zapewnienie ciągłości wizualnej w sekwencjach filmowych

Opcje Kontroli Regionalnej:

- Wyrazy Oczu: Zachowuje mrużenie, rozszerzanie oczu i pozycjonowanie powiek

- Wyrazy Brwi: Utrzymuje pozycjonowanie brwi i czoła

- Kształt Ust: Zachowuje ogólne zakrzywienie ust, pozwalając na resetowanie ruchów mowy (język, szczęka)

Łączenie z Istniejącymi Animacjami

Aby zastosować synchronizację warg i śmiech wraz z istniejącymi animacjami ciała i niestandardowymi animacjami twarzy bez ich nadpisywania:

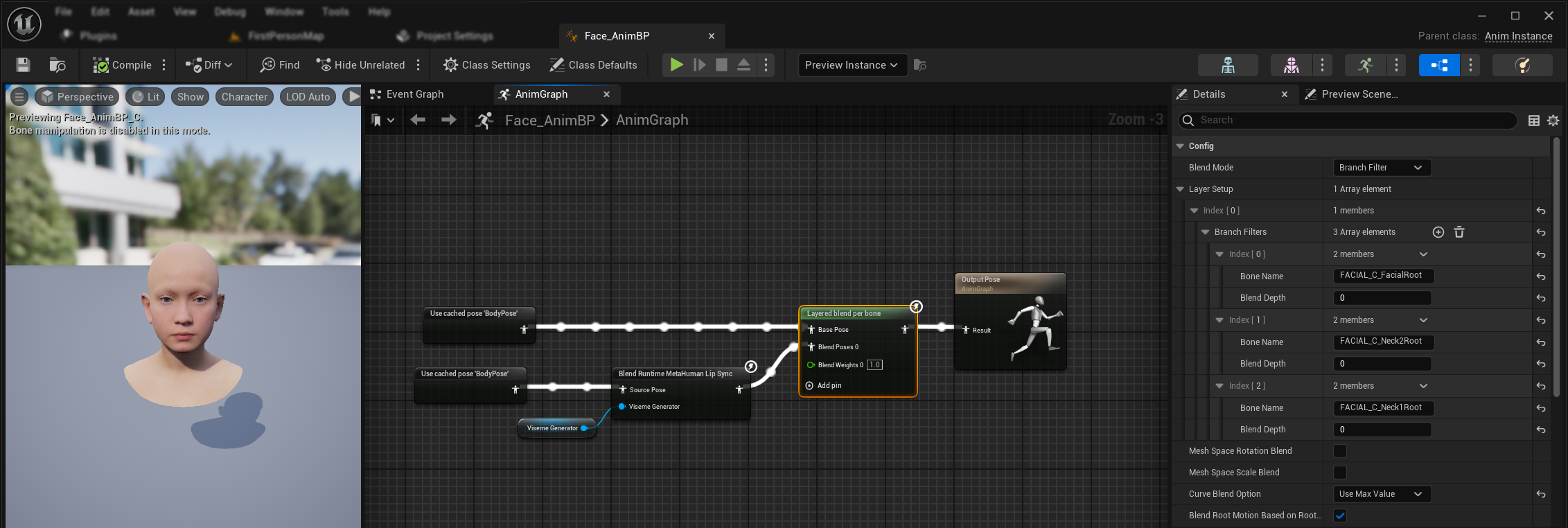

- Dodaj węzeł

Layered blend per bonemiędzy swoimi animacjami ciała a ostatecznym wyjściem. Upewnij się, żeUse Attached Parentjest ustawione na true. - Skonfiguruj ustawienia warstw:

- Dodaj 1 element do tablicy

Layer Setup - Dodaj 3 elementy do

Branch Filtersdla warstwy, z następującymiBone Name:FACIAL_C_FacialRootFACIAL_C_Neck2RootFACIAL_C_Neck1Root

- Dodaj 1 element do tablicy

- Ważne dla niestandardowych animacji twarzy: W

Curve Blend Optionwybierz "Use Max Value". Pozwala to na prawidłowe nakładanie niestandardowych animacji twarzy (wyrazy, emocje itp.) na synchronizację warg. - Wykonaj połączenia:

- Istniejące animacje (takie jak

BodyPose) → wejścieBase Pose - Wyjście animacji twarzy (z węzłów synchronizacji warg i/lub śmiechu) → wejście

Blend Poses 0 - Węzeł warstwowy → końcowa poza

Result

- Istniejące animacje (takie jak

Wybór Zestawu Morph Target

- Standard Model

- Realistic Models

Model Standardowy używa zasobów poz (pose assets), które z natury obsługują dowolną konwencję nazewnictwa morph target poprzez konfigurację niestandardowego zasobu poz. Nie jest potrzebna dodatkowa konfiguracja.

Węzeł Blend Realistic MetaHuman Lip Sync zawiera właściwość Morph Target Set, która określa, której konwencji nazewnictwa morph target używać do animacji twarzy:

| Zestaw Morph Target | Opis | Zastosowania |

|---|---|---|

| MetaHuman (Domyślny) | Standardowe nazwy morph target MetaHumana (np. CTRL_expressions_jawOpen) | Postacie MetaHuman |

| ARKit | Nazwy zgodne z Apple ARKit (np. JawOpen, MouthSmileLeft) | Postacie oparte na ARKit |

Precyzyjne Dostrajanie Zachowania Synchronizacji Warg

Kontrola Wysuwania Języka

W standardowym modelu synchronizacji warg możesz zauważyć nadmierne wysuwanie języka do przodu podczas niektórych fonemów. Aby kontrolować wysuwanie języka:

- Po węźle mieszania synchronizacji warg dodaj węzeł

Modify Curve - Kliknij prawym przyciskiem myszy na węźle

Modify Curvei wybierz Add Curve Pin - Dodaj pin krzywej o nazwie

CTRL_expressions_tongueOut - Ustaw właściwość Apply Mode węzła na Scale

- Dostosuj parametr Value, aby kontrolować wysunięcie języka (np. 0.8, aby zmniejszyć wysunięcie o 20%)

Kontrola Otwarcia Szczęki

Realistyczna synchronizacja warg może generować nadmiernie responsywne ruchy szczęki w zależności od treści audio i wymagań wizualnych. Aby dostosować intensywność otwarcia szczęki:

- Po węźle mieszania synchronizacji warg dodaj węzeł

Modify Curve - Kliknij prawym przyciskiem myszy na węźle

Modify Curvei wybierz Add Curve Pin - Dodaj pin krzywej o nazwie

CTRL_expressions_jawOpen - Ustaw właściwość Apply Mode węzła na Scale

- Dostosuj parametr Value, aby kontrolować zakres otwarcia szczęki (np. 0.9, aby zmniejszyć ruch szczęki o 10%)

Precyzyjne Dostrajanie Specyficzne dla Nastroju

Dla modeli z obsługą nastroju możesz precyzyjnie dostroić specyficzne wyrazy emocjonalne:

Kontrola Brwi:

CTRL_expressions_browRaiseInL/CTRL_expressions_browRaiseInR- Podnoszenie wewnętrznej części brwiCTRL_expressions_browRaiseOuterL/CTRL_expressions_browRaiseOuterR- Podnoszenie zewnętrznej części brwiCTRL_expressions_browDownL/CTRL_expressions_browDownR- Opuszczanie brwi

Kontrola Wyrazu Oczu:

CTRL_expressions_eyeSquintInnerL/CTRL_expressions_eyeSquintInnerR- Mrużenie oczuCTRL_expressions_eyeCheekRaiseL/CTRL_expressions_eyeCheekRaiseR- Podnoszenie policzków

Porównanie i Wybór Modelu

Wybór Między Modelami

Decydując, którego modelu synchronizacji warg użyć w swoim projekcie, rozważ te czynniki:

| Rozważanie | Model Standardowy | Model Realistyczny | Model Realistyczny z Obsługą Nastroju |

|---|---|---|---|

| Kompatybilność z Postaciami | MetaHumans i wszystkie typy niestandardowych postaci | Postacie MetaHuman (i ARKit) | Postacie MetaHuman (i ARKit) |

| Jakość Wizualna | Dobra synchronizacja warg z wydajną wydajnością | Zwiększony realizm z bardziej naturalnymi ruchami ust | Zwiększony realizm z emocjonalnymi wyrazami |

| Wydajność | Zoptymalizowany dla wszystkich platform, w tym mobilnych/VR | Wyższe wymagania zasobowe | Wyższe wymagania zasobowe |

| Funkcje | 14 wizemów, wykrywanie śmiechu | 81 kontrolek twarzy, 3 poziomy optymalizacji | 81 kontrolek twarzy, 12 nastrojów, konfigurowalne wyjście |

| Obsługa Platform | Windows, Android, Quest | Windows, Mac, iOS, Linux, Android, Quest | Windows, Mac, iOS, Linux, Android, Quest |

| Zastosowania | Aplikacje ogólne, gry, VR/AR, mobilne | Doświadczenia filmowe, interakcje z bliska | Opowiadanie emocjonalne, zaawansowana interakcja z postaciami |

Kompatybilność z Wersją Silnika

Jeśli używasz Unreal Engine 5.2, modele Realistyczne mogą nie działać poprawnie z powodu błędu w bibliotece próbkowania UE. Dla użytkowników UE 5.2, którzy potrzebują niezawodnej funkcjonalności synchronizacji warg, proszę używać Modelu Standardowego zamiast tego.

Ten problem jest specyficzny dla UE 5.2 i nie dotyczy innych wersji silnika.

Zalecenia Wydajnościowe

- Dla większości projektów Model Standardowy zapewnia doskonałą równowagę jakości i wydajności

- Użyj Modelu Realistycznego, gdy potrzebujesz najwyższej wierności wizualnej dla postaci MetaHuman

- Użyj Modelu Realistycznego z Obsługą Nastroju, gdy kontrola wyrażania emocji jest ważna dla twojej aplikacji

- Rozważ możliwości wydajnościowe platformy docelowej przy wyborze między modelami

- Przetestuj różne poziomy optymalizacji, aby znaleźć najlepszą równowagę dla swojego konkretnego przypadku użycia

Kompatybilność z TTS

| Typ Modelu | Obsługa Lokalnego TTS (poprzez Runtime Text To Speech) | Obsługa Zewnętrznego TTS | Uwagi |

|---|---|---|---|

| Model Standardowy | ✅ Pełna obsługa | ✅ Pełna obsługa | Kompatybilny ze wszystkimi opcjami TTS |

| Model Realistyczny | ❌ Ograniczona obsługa | ✅ Pełna obsługa | Konflikty środowiska wykonawczego ONNX z lokalnym TTS |

| Model Realistyczny z Obsługą Nastroju | ✅ Pełna obsługa | ✅ Pełna obsługa | Kompatybilny ze wszystkimi opcjami TTS |

Rozwiązywanie Problemów

Typowe Problemy

Ponowne Tworzenie Generatora dla Modeli Realistycznych: Dla niezawodnej i spójnej pracy z Modelami Realistycznymi zaleca się ponowne tworzenie generatora za każdym razem, gdy chcesz przekazać nowe dane audio po okresie bezczynności. Wynika to z zachowania środowiska wykonawczego ONNX, które może spowodować zatrzymanie działania synchronizacji warg przy ponownym używaniu generatorów po okresach ciszy.

Kompatybilność z Lokalnym TTS: Lokalne TTS dostarczane przez wtyczkę Runtime Text To Speech nie jest obecnie obsługiwane z regularnym modelem Realistycznym z powodu konfliktów środowiska wykonawczego ONNX. Jest jednak w pełni kompatybilne zarówno z modelem Standardowym, jak i modelem Realistycznym z Obsługą Nastroju. Używaj zewnętrznych usług TTS, jeśli konkretnie potrzebujesz regularnego modelu Realistycznego z funkcjonalnością TTS.

Obniżona Responsywność Synchronizacji Warg: Jeśli doświadczasz, że synchronizacja warg staje się mniej responsywna w czasie przy użyciu Streaming Sound Wave lub Capturable Sound Wave, może to być spowodowane akumulacją pamięci. Domyślnie pamięć jest realokowana za każdym razem, gdy nowe audio jest dołączane. Aby zapobiec temu problemowi, wywołaj funkcję ReleaseMemory okresowo, aby zwolnić zgromadzoną pamięć, na przykład co 30 sekund lub podobnie.

Optymalizacja Wydajności:

- Dostosuj Processing Chunk Size dla modeli Realistycznych na podstawie wymagań wydajnościowych

- Używaj odpowiednich liczby wątków dla docelowego sprzętu

- Rozważ użycie typu wyjścia Mouth Only dla modeli z obsługą nastroju, gdy pełna animacja twarzy nie jest potrzebna