Plugin-Konfiguration

Modellkonfiguration

Standardmodell-Konfiguration

Der Create Runtime Viseme Generator-Knoten verwendet Standardeinstellungen, die für die meisten Szenarien gut funktionieren. Die Konfiguration erfolgt über die Eigenschaften des Animation Blueprint-Blending-Knotens.

Für Animation Blueprint-Konfigurationsoptionen siehe den Abschnitt Lip Sync Configuration unten.

Realistisches Modell-Konfiguration

Der Create Realistic MetaHuman Lip Sync Generator-Knoten akzeptiert einen optionalen Configuration-Parameter, der es ermöglicht, das Verhalten des Generators anzupassen:

Modelltyp

Die Einstellung Model Type bestimmt, welche Version des realistischen Modells verwendet wird:

| Modelltyp | Leistung | Visuelle Qualität | Rauschbehandlung | Empfohlene Anwendungsfälle |

|---|---|---|---|---|

| Hoch optimiert (Standard) | Höchste Leistung, niedrigste CPU-Auslastung | Gute Qualität | Kann merkliche Mundbewegungen bei Hintergrundgeräuschen oder Nicht-Sprach-Geräuschen zeigen | Saubere Audio-Umgebungen, leistungskritische Szenarien |

| Teilweise optimiert | Gute Leistung, moderate CPU-Auslastung | Hohe Qualität | Bessere Stabilität bei verrauschtem Audio | Ausgewogene Leistung und Qualität, gemischte Audio-Bedingungen |

| Original | Geeignet für Echtzeitanwendung auf modernen CPUs | Höchste Qualität | Stabilste bei Hintergrundgeräuschen und Nicht-Sprach-Geräuschen | Hochwertige Produktionen, verrauschte Audio-Umgebungen, wenn maximale Genauigkeit benötigt wird |

Leistungseinstellungen

Intra Op Threads: Steuert die Anzahl der Threads, die für interne Modellverarbeitungsoperationen verwendet werden.

- 0 (Standard/Automatisch): Verwendet automatische Erkennung (typischerweise 1/4 der verfügbaren CPU-Kerne, maximal 4)

- 1-16: Thread-Anzahl manuell angeben. Höhere Werte können die Leistung auf Multi-Core-Systemen verbessern, verbrauchen aber mehr CPU

Inter Op Threads: Steuert die Anzahl der Threads, die für die parallele Ausführung verschiedener Modelloperationen verwendet werden.

- 0 (Standard/Automatisch): Verwendet automatische Erkennung (typischerweise 1/8 der verfügbaren CPU-Kerne, maximal 2)

- 1-8: Thread-Anzahl manuell angeben. Wird normalerweise niedrig für die Echtzeitverarbeitung gehalten

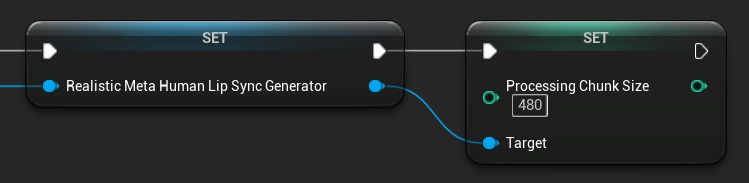

Verarbeitungs-Chunk-Größe

Die Processing Chunk Size bestimmt, wie viele Samples in jedem Inferenzschritt verarbeitet werden. Der Standardwert ist 160 Samples (10ms Audio bei 16kHz):

- Kleinere Werte bieten häufigere Updates, erhöhen aber die CPU-Auslastung

- Größere Werte reduzieren die CPU-Last, können aber die Lippenbewegungs-Reaktionsfähigkeit verringern

- Empfohlen, Vielfache von 160 für optimale Ausrichtung zu verwenden

Stimmungsfähiges Modell-Konfiguration

Der Create Realistic MetaHuman Lip Sync With Mood Generator-Knoten bietet zusätzliche Konfigurationsoptionen über das grundlegende realistische Modell hinaus:

Grundkonfiguration

Lookahead Ms: Vorausschauzeit in Millisekunden für verbesserte Lippenbewegungs-Genauigkeit.

- Standard: 80ms

- Bereich: 20ms bis 200ms (muss durch 20 teilbar sein)

- Höhere Werte bieten bessere Synchronisation, erhöhen aber die Latenz

Output Type: Steuert, welche Gesichtssteuerungen generiert werden.

- Full Face: Alle 81 Gesichtssteuerungen (Augenbrauen, Augen, Nase, Mund, Kiefer, Zunge)

- Mouth Only: Nur Mund-, Kiefer- und Zungen-bezogene Steuerungen

Performance Settings: Verwendet die gleichen Intra Op Threads- und Inter Op Threads-Einstellungen wie das reguläre realistische Modell.

Stimmungseinstellungen

Verfügbare Stimmungen:

- Neutral, Happy, Sad, Disgust, Anger, Surprise, Fear

- Confident, Excited, Bored, Playful, Confused

Mood Intensity: Steuert, wie stark die Stimmung die Animation beeinflusst (0.0 bis 1.0)

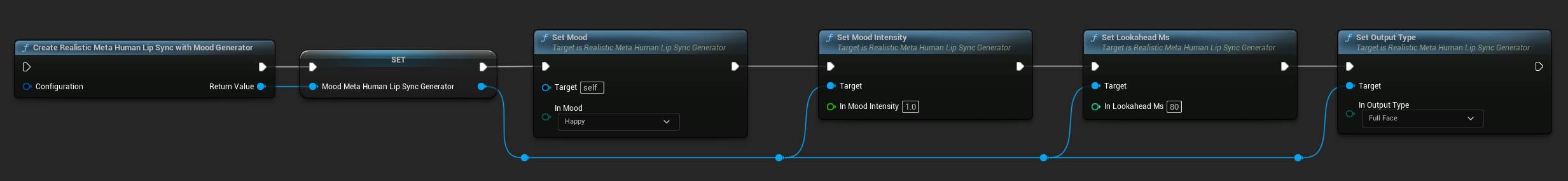

Laufzeit-Stimmungssteuerung

Sie können Stimmungseinstellungen während der Laufzeit mit den folgenden Funktionen anpassen:

- Set Mood: Ändert den aktuellen Stimmungstyp

- Set Mood Intensity: Passt an, wie stark die Stimmung die Animation beeinflusst (0.0 bis 1.0)

- Set Lookahead Ms: Ändert die Vorausschauzeit für die Synchronisation

- Set Output Type: Wechselt zwischen Full Face- und Mouth Only-Steuerungen

Stimmungsauswahl-Leitfaden

Wählen Sie geeignete Stimmungen basierend auf Ihrem Inhalt:

| Stimmung | Am besten geeignet für | Typischer Intensitätsbereich |

|---|---|---|

| Neutral | Allgemeine Konversation, Erzählung, Standardzustand | 0.5 - 1.0 |

| Happy | Positive Inhalte, fröhliche Dialoge, Feierlichkeiten | 0.6 - 1.0 |

| Sad | Melancholische Inhalte, emotionale Szenen, düstere Momente | 0.5 - 0.9 |

| Disgust | Negative Reaktionen, widerliche Inhalte, Ablehnung | 0.4 - 0.8 |

| Anger | Aggressive Dialoge, konfrontative Szenen, Frustration | 0.6 - 1.0 |

| Surprise | Unerwartete Ereignisse, Enthüllungen, Schockreaktionen | 0.7 - 1.0 |

| Fear | Bedrohliche Situationen, Angst, nervöse Dialoge | 0.5 - 0.9 |

| Confident | Professionelle Präsentationen, Führungsdialoge, bestimmende Sprache | 0.7 - 1.0 |

| Excited | Energetische Inhalte, Ankündigungen, enthusiastische Dialoge | 0.8 - 1.0 |

| Bored | Monotone Inhalte, desinteressierte Dialoge, müde Sprache | 0.3 - 0.7 |

| Playful | Gelegentliche Konversation, Humor, unbeschwerte Interaktionen | 0.6 - 0.9 |

| Confused | Fragenreiche Dialoge, Unsicherheit, Verwirrung | 0.4 - 0.8 |

Animation Blueprint-Konfiguration

Lippenbewegungs-Konfiguration

- Standardmodell

- Realistische Modelle

Der Blend Runtime MetaHuman Lip Sync-Knoten hat Konfigurationsoptionen in seinem Eigenschaften-Bedienfeld:

| Eigenschaft | Standard | Beschreibung |

|---|---|---|

| Interpolation Speed | 25 | Steuert, wie schnell die Lippenbewegungen zwischen Visemen übergehen. Höhere Werte führen zu schnelleren, abrupten Übergängen. |

| Reset Time | 0.2 | Die Dauer in Sekunden, nach der die Lippenbewegung zurückgesetzt wird. Dies ist nützlich, um zu verhindern, dass die Lippenbewegung fortgesetzt wird, nachdem das Audio gestoppt hat. |

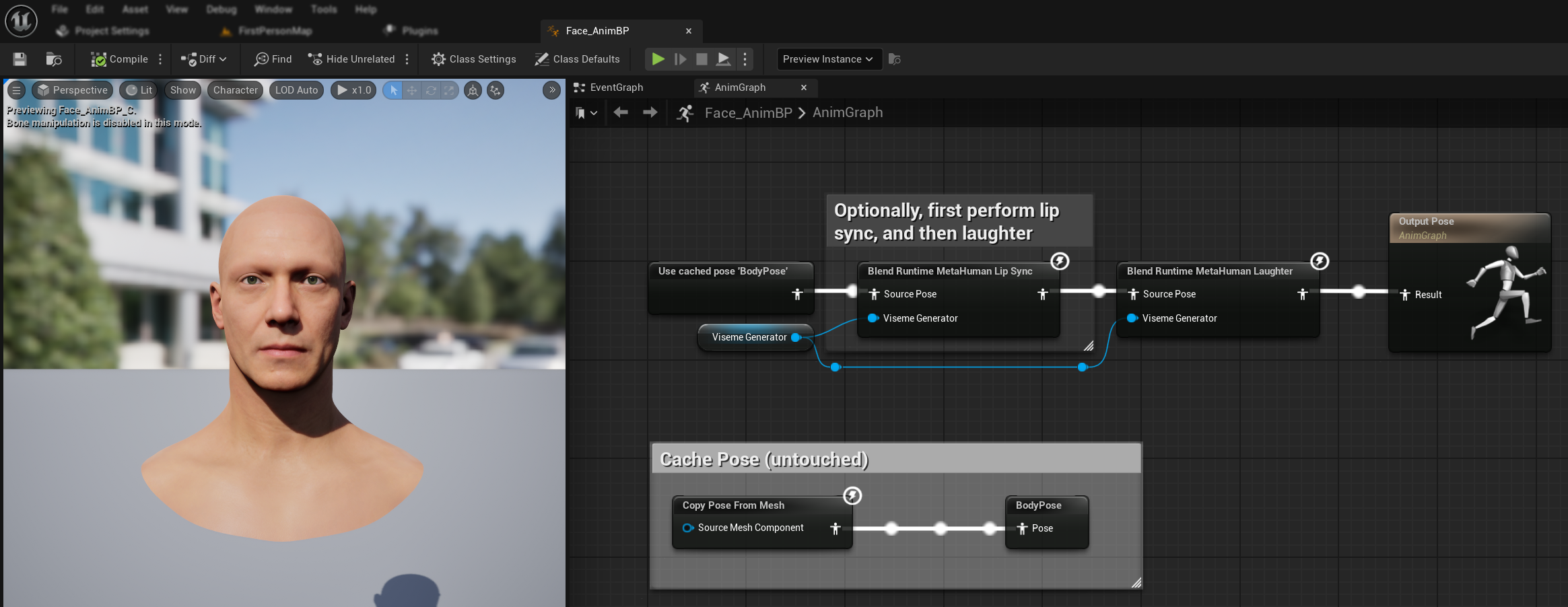

Lachen-Animation

Sie können auch Lachen-Animationen hinzufügen, die dynamisch auf im Audio erkanntes Lachen reagieren:

- Fügen Sie den

Blend Runtime MetaHuman Laughter-Knoten hinzu - Verbinden Sie Ihre

RuntimeVisemeGenerator-Variable mit demViseme Generator-Pin - Wenn Sie bereits Lippenbewegung verwenden:

- Verbinden Sie die Ausgabe vom

Blend Runtime MetaHuman Lip Sync-Knoten mit demSource PosedesBlend Runtime MetaHuman Laughter-Knotens - Verbinden Sie die Ausgabe des

Blend Runtime MetaHuman Laughter-Knotens mit demResult-Pin derOutput Pose

- Verbinden Sie die Ausgabe vom

- Wenn Sie nur Lachen ohne Lippenbewegung verwenden:

- Verbinden Sie Ihre Quellpose direkt mit dem

Source PosedesBlend Runtime MetaHuman Laughter-Knotens - Verbinden Sie die Ausgabe mit dem

Result-Pin

- Verbinden Sie Ihre Quellpose direkt mit dem

Wenn Lachen im Audio erkannt wird, wird Ihr Charakter entsprechend dynamisch animiert:

Lachen-Konfiguration

Der Blend Runtime MetaHuman Laughter-Knoten hat seine eigenen Konfigurationsoptionen:

| Eigenschaft | Standard | Beschreibung |

|---|---|---|

| Interpolation Speed | 25 | Steuert, wie schnell die Lippenbewegungen zwischen Lachen-Animationen übergehen. Höhere Werte führen zu schnelleren, abrupten Übergängen. |

| Reset Time | 0.2 | Die Dauer in Sekunden, nach der das Lachen zurückgesetzt wird. Dies ist nützlich, um zu verhindern, dass das Lachen fortgesetzt wird, nachdem das Audio gestoppt hat. |

| Max Laughter Weight | 0.7 | Skaliert die maximale Intensität der Lachen-Animation (0.0 - 1.0). |

Hinweis: Lachen-Erkennung ist derzeit nur mit dem Standardmodell verfügbar.

Der Blend Realistic MetaHuman Lip Sync-Knoten hat Konfigurationsoptionen in seinem Eigenschaften-Bedienfeld:

| Eigenschaft | Standard | Beschreibung |

|---|---|---|

| Interpolation Speed | 30 | Steuert, wie schnell Gesichtsausdrücke während aktiver Sprache übergehen. Höhere Werte führen zu schnelleren, abrupten Übergängen. |

| Idle Interpolation Speed | 15 | Steuert, wie schnell Gesichtsausdrücke in den Leerlauf-/Neutralzustand zurückkehren. Niedrigere Werte erzeugen glattere, allmählichere Rückkehr zur Ruhepose. |

| Reset Time | 0.2 | Dauer in Sekunden, nach der die Lippenbewegung in den Leerlaufzustand zurückgesetzt wird. Nützlich, um zu verhindern, dass Ausdrücke fortgesetzt werden, nachdem das Audio gestoppt hat. |

| Preserve Idle State | false | Wenn aktiviert, bewahrt den letzten emotionalen Zustand während Leerlaufperioden anstatt auf neutral zurückzusetzen. |

| Preserve Eye Expressions | true | Steuert, ob augenbezogene Gesichtssteuerungen im Leerlaufzustand bewahrt werden. Nur wirksam, wenn Preserve Idle State aktiviert ist. |

| Preserve Brow Expressions | true | Steuert, ob augenbrauenbezogene Gesichtssteuerungen im Leerlaufzustand bewahrt werden. Nur wirksam, wenn Preserve Idle State aktiviert ist. |

| Preserve Mouth Shape | false | Steuert, ob Mundform-Steuerungen (ausgenommen sprachspezifische Bewegungen wie Zunge und Kiefer) im Leerlaufzustand bewahrt werden. Nur wirksam, wenn Preserve Idle State aktiviert ist. |

Leerlaufzustands-Bewahrung

Die Preserve Idle State-Funktion behandelt, wie das Realistische Modell Stilleperioden handhabt. Im Gegensatz zum Standardmodell, das diskrete Viseme verwendet und während Stille konsistent auf Nullwerte zurückkehrt, kann das neuronale Netz des Realistischen Modells subtile Gesichtspositionierung beibehalten, die sich von der Standard-Ruhepose des MetaHuman unterscheidet.

Wann zu aktivieren:

- Beibehaltung emotionaler Ausdrücke zwischen Sprachsegmenten

- Bewahrung von Charakter-Persönlichkeitsmerkmalen

- Sicherstellung visueller Kontinuität in filmischen Sequenzen

Regionale Steuerungsoptionen:

- Eye Expressions: Bewahrt Augen-Zusammenkneifen, Weitöffnen und Augenlid-Positionierung

- Brow Expressions: Behält Augenbrauen- und Stirn-Positionierung bei

- Mouth Shape: Behält allgemeine Mundkrümmung bei, während Sprachbewegungen (Zunge, Kiefer) zurückgesetzt werden können

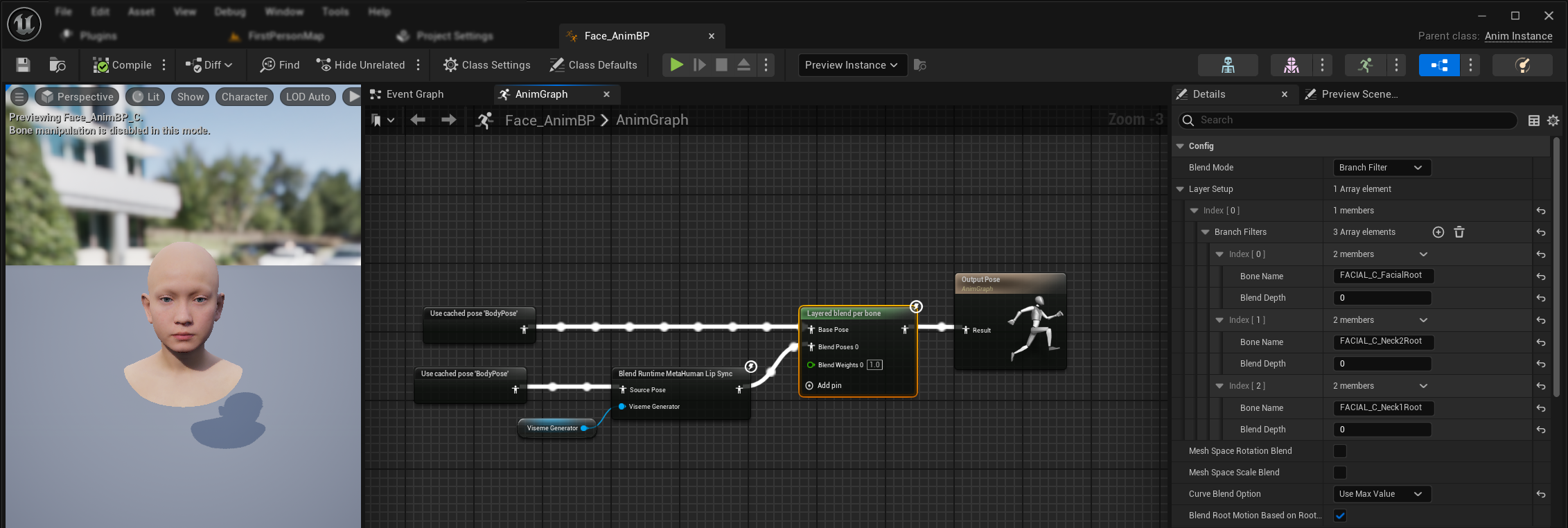

Kombinieren mit bestehenden Animationen

Um Lippenbewegung und Lachen neben bestehenden Körperanimationen und benutzerdefinierten Gesichtsanimationen anzuwenden, ohne sie zu überschreiben:

- Fügen Sie einen

Layered blend per bone-Knoten zwischen Ihre Körperanimationen und die endgültige Ausgabe hinzu. Stellen Sie sicher, dassUse Attached Parentwahr ist. - Konfigurieren Sie das Layer-Setup:

- Fügen Sie 1 Item zum

Layer Setup-Array hinzu - Fügen Sie 3 Items zu den

Branch Filtersfür den Layer hinzu, mit den folgendenBone Names:FACIAL_C_FacialRootFACIAL_C_Neck2RootFACIAL_C_Neck1Root

- Fügen Sie 1 Item zum

- Wichtig für benutzerdefinierte Gesichtsanimationen: Wählen Sie in

Curve Blend Option"Use Max Value". Dies ermöglicht es, benutzerdefinierte Gesichtsanimationen (Ausdrücke, Emotionen, etc.) korrekt über der Lippenbewegung zu schichten. - Stellen Sie die Verbindungen her:

- Bestehende Animationen (wie

BodyPose) →Base Pose-Eingabe - Gesichtsanimationsausgabe (von Lippenbewegungs- und/oder Lachen-Knoten) →

Blend Poses 0-Eingabe - Layered blend-Knoten → Endgültige

Result-Pose

- Bestehende Animationen (wie

Morph Target Set-Auswahl

- Standardmodell

- Realistische Modelle

Das Standardmodell verwendet Pose-Assets, die durch das benutzerdefinierte Pose-Asset-Setup inhärent jede Morph Target-Namenskonvention unterstützen. Keine zusätzliche Konfiguration ist erforderlich.

Der Blend Realistic MetaHuman Lip Sync-Knoten enthält eine Morph Target Set-Eigenschaft, die bestimmt, welche Morph Target-Namenskonvention für die Gesichtsanimation verwendet wird:

| Morph Target Set | Beschreibung | Anwendungsfälle |

|---|---|---|

| MetaHuman (Standard) | Standard MetaHuman Morph Target-Namen (z.B. CTRL_expressions_jawOpen) | MetaHuman-Charaktere |

| ARKit | Apple ARKit-kompatible Namen (z.B. JawOpen, MouthSmileLeft) | ARKit-basierte Charaktere |

Feinabstimmung des Lippenbewegungs-Verhaltens

Zungenvorstoß-Steuerung

Im Standard-Lippenbewegungsmodell können Sie übermäßige Vorwärtsbewegung der Zunge während bestimmter Phoneme bemerken. Um den Zungenvorstoß zu steuern:

- Fügen Sie nach Ihrem Lippenbewegungs-Blend-Knoten einen

Modify Curve-Knoten hinzu - Klicken Sie mit der rechten Maustaste auf den

Modify Curve-Knoten und wählen Sie Add Curve Pin - Fügen Sie einen Curve-Pin mit dem Namen

CTRL_expressions_tongueOuthinzu - Setzen Sie die Apply Mode-Eigenschaft des Knotens auf Scale

- Passen Sie den Value-Parameter an, um die Zungenausdehnung zu steuern (z.B. 0.8, um den Vorstoß um 20% zu reduzieren)

Kieferöffnungs-Steuerung

Die realistische Lippenbewegung kann übermäßig responsive Kieferbewegungen erzeugen, abhängig von Ihrem Audioinhalt und visuellen Anforderungen. Um die Kieferöffnungsintensität anzupassen:

- Fügen Sie nach Ihrem Lippenbewegungs-Blend-Knoten einen

Modify Curve-Knoten hinzu - Klicken Sie mit der rechten Maustaste auf den

Modify Curve-Knoten und wählen Sie Add Curve Pin - Fügen Sie einen Curve-Pin mit dem Namen

CTRL_expressions_jawOpenhinzu - Setzen Sie die Apply Mode-Eigenschaft des Knotens auf Scale

- Passen Sie den Value-Parameter an, um den Kieferöffnungsbereich zu steuern (z.B. 0.9, um die Kieferbewegung um 10% zu reduzieren)

Stimmungsspezifische Feinabstimmung

Für stimmungsfähige Modelle können Sie spezifische emotionale Ausdrücke feinabstimmen:

Augenbrauen-Steuerung:

CTRL_expressions_browRaiseInL/CTRL_expressions_browRaiseInR- Innere AugenbrauenhebungCTRL_expressions_browRaiseOuterL/CTRL_expressions_browRaiseOuterR- Äußere AugenbrauenhebungCTRL_expressions_browDownL/CTRL_expressions_browDownR- Augenbrauensenkung

Augenausdrucks-Steuerung:

CTRL_expressions_eyeSquintInnerL/CTRL_expressions_eyeSquintInnerR- Augen-ZusammenkneifenCTRL_expressions_eyeCheekRaiseL/CTRL_expressions_eyeCheekRaiseR- Wangenhebung

Modellvergleich und -auswahl

Auswahl zwischen Modellen

Berücksichtigen Sie bei der Entscheidung, welches Lippenbewegungsmodell für Ihr Projekt verwendet werden soll, diese Faktoren:

| Überlegung | Standardmodell | Realistisches Modell | Stimmungsfähiges Realistisches Modell |

|---|---|---|---|

| Charakterkompatibilität | MetaHumans und alle benutzerdefinierten Charaktertypen | MetaHumans (und ARKit)-Charaktere | MetaHumans (und ARKit)-Charaktere |

| Visuelle Qualität | Gute Lippenbewegung mit effizienter Leistung | Verbesserter Realismus mit natürlicheren Mundbewegungen | Verbesserter Realismus mit emotionalen Ausdrücken |

| Leistung | Für alle Plattformen einschließlich Mobile/VR optimiert | Höhere Ressourcenanforderungen | Höhere Ressourcenanforderungen |

| Funktionen | 14 Viseme, Lachen-Erkennung | 81 Gesichtssteuerungen, 3 Optimierungsstufen | 81 Gesichtssteuerungen, 12 Stimmungen, konfigurierbare Ausgabe |

| Plattformunterstützung | Windows, Android, Quest | Windows, Mac, iOS, Linux, Android, Quest | Windows, Mac, iOS, Linux, Android, Quest |

| Anwendungsfälle | Allgemeine Anwendungen, Spiele, VR/AR, Mobile | Filmische Erfahrungen, Nahaufnahme-Interaktionen | Emotionelles Storytelling, fortgeschrittene Charakterinteraktion |

Engine-Version-Kompatibilität

Wenn Sie Unreal Engine 5.2 verwenden, funktionieren die Realistischen Modelle möglicherweise nicht korrekt aufgrund eines Fehlers in UEs Resampling-Bibliothek. Für UE 5.2-Benutzer, die zuverlässige Lippenbewegungsfunktionalität benötigen, verwenden Sie bitte stattdessen das Standardmodell.

Dieses Problem ist spezifisch für UE 5.2 und betrifft keine anderen Engine-Versionen.

Leistungsempfehlungen

- Für die meisten Projekte bietet das Standardmodell eine ausgezeichnete Balance aus Qualität und Leistung

- Verwenden Sie das Realistische Modell, wenn Sie die höchste visuelle Wiedergabetreue für MetaHuman-Charaktere benötigen

- Verwenden Sie das Stimmungsfähige Realistische Modell, wenn die emotionale Ausdruckssteuerung für Ihre Anwendung wichtig ist

- Berücksichtigen Sie die Leistungsfähigkeiten Ihrer Zielplattform bei der Auswahl zwischen Modellen

- Testen Sie verschiedene Optimierungsstufen, um die beste Balance für Ihren spezifischen Anwendungsfall zu finden

TTS-Kompatibilität

| Modelltyp | Lokale TTS-Unterstützung (via Runtime Text To Speech) | Externe TTS-Unterstützung | Hinweise |

|---|---|---|---|

| Standardmodell | ✅ Volle Unterstützung | ✅ Volle Unterstützung | Kompatibel mit allen TTS-Optionen |

| Realistisches Modell | ❌ Eingeschränkte Unterstützung | ✅ Volle Unterstützung | ONNX-Laufzeitkonflikte mit lokaler TTS |

| Stimmungsfähiges Realistisches Modell | ✅ Volle Unterstützung | ✅ Volle Unterstützung | Kompatibel mit allen TTS-Optionen |

Fehlerbehebung

Häufige Probleme

Generator-Neuerstellung für Realistische Modelle: Für zuverlässigen und konsistenten Betrieb mit den Realistischen Modellen wird empfohlen, den Generator jedes Mal neu zu erstellen, wenn Sie nach einer Inaktivitätsperiode neue Audiodaten zuführen möchten. Dies liegt am ONNX-Laufzeitverhalten, das dazu führen kann, dass die Lippenbewegung aufhört zu funktionieren, wenn Generatoren nach Stilleperioden wiederverwendet werden.

Lokale TTS-Kompatibilität: Lokale TTS, bereitgestellt durch das Runtime Text To Speech-Plugin, wird derzeit mit dem regulären Realistischen Modell aufgrund von ONNX-Laufzeitkonflikten nicht unterstützt. Sie ist jedoch vollständig kompatibel mit sowohl dem Standardmodell als auch dem Stimmungsfähigen Realistischen Modell. Verwenden Sie externe TTS-Dienste, wenn Sie spezifisch das reguläre Realistische Modell mit TTS-Funktionalität benötigen.

Verschlechterte Lippenbewegungs-Reaktionsfähigkeit: Wenn Sie feststellen, dass die Lippenbewegung über die Zeit weniger reaktionsfähig wird, wenn Sie Streaming Sound Wave oder Capturable Sound Wave verwenden, kann dies durch Speicheransammlung verursacht werden. Standardmäßig wird der Speicher jedes Mal neu zugewiesen, wenn neues Audio angehängt wird. Um dieses Problem zu verhindern, rufen Sie die ReleaseMemory-Funktion periodisch auf, um angesammelten Speicher freizugeben, z.B. alle 30 Sekunden oder so.

Leistungsoptimierung:

- Passen Sie die Processing Chunk Size für Realistische Modelle basierend auf Ihren Leistungsanforderungen an

- Verwenden Sie angemessene Thread-Anzahlen für Ihre Zielhardware

- Erwägen Sie die Verwendung des Mouth Only-Ausgabetyps für stimmungsfähige Modelle, wenn die vollständige Gesichtsanimation nicht benötigt wird